TPU(Tensor Processing Unit)는 구글이 개발한 특수한 하드웨어로, 머신 러닝 워크로드를 가속화하기 위해 설계된 프로세서입니다. 이 프로세서는 특히 대규모 신경망 모델의 훈련과 추론 작업을 처리하는 데 효율적으로 작동합니다. TPU의 개념, 동작 원리, 사용 사례, 그리고 기술적인 세부 사항에 대해 더 자세히 알아보겠습니다.

1. TPU의 개념

TPU는 텐서 연산을 위해 특별히 최적화된 하드웨어입니다. 텐서는 다차원 데이터 배열을 나타내며, 머신 러닝에서 주로 사용됩니다. TPU는 주로 구글의 텐서플로우(TensorFlow)와 같은 딥러닝 프레임워크와 함께 사용되며, 이러한 프레임워크의 작업을 효율적으로 처리하기 위해 설계되었습니다.

2. TPU의 동작 원리

TPU는 딥러닝 모델의 계산 부하를 처리하기 위해 특수한 형태의 신경망 가속기입니다. 이러한 가속기는 텐서 연산을 병렬로 처리할 수 있으며, 대규모 신경망 모델의 병렬 처리를 지원합니다. 또한 TPU는 전력 효율을 최적화하여 대규모 머신 러닝 워크로드를 처리하는 데 필요한 전력을 최소화합니다.

3. TPU의 사용 사례

TPU는 다음과 같은 주요 사용 사례에서 활용됩니다:

- 대규모 신경망 모델의 훈련 및 추론: TPU는 대규모 이미지 분류, 자연어 처리, 음성 인식 등과 같은 복잡한 머신 러닝 모델의 훈련 및 추론을 가속화합니다.

- 실시간 예측 및 추론: TPU는 실시간 예측 및 추론을 필요로 하는 응용 프로그램에 사용됩니다. 예를 들어, 온라인 광고, 음성 인식, 얼굴 인식 등의 응용 프로그램에서 사용될 수 있습니다.

4. TPU의 기술적인 세부 사항

TPU는 다음과 같은 기술적인 특징을 가지고 있습니다:

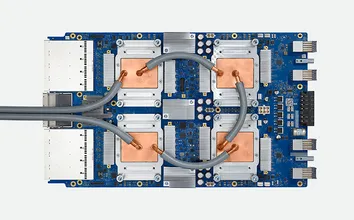

- 고유한 아키텍처: TPU는 텐서 연산을 위해 특별히 설계된 아키텍처를 사용합니다. 이 아키텍처는 병렬 처리 및 전력 효율을 최적화하도록 설계되었습니다.

- 대규모 병렬 처리: TPU는 수천 개의 코어를 가지고 있으며, 이러한 코어는 텐서 연산을 병렬로 처리합니다. 이러한 병렬 처리는 대규모 신경망 모델의 훈련 및 추론을 가속화합니다.

- 전력 효율: TPU는 전력 효율을 최적화하여 대규모 머신 러닝 워크로드를 처리하는 데 필요한 전력을 최소화합니다. 이는 데이터 센터에서 전력 소비를 줄이고 에너지 효율성을 향상시킵니다.

5. TPU의 발전 및 미래

TPU는 지속적으로 발전하고 있으며, 머신 러닝 및 딥러닝 워크로드를 처리하는 데 필요한 성능과 효율성을 향상시키는 데 주력하고 있습니다. 또한 TPU는 클라우드 기반의 머신 러닝 서비스에서 널리 사용되고 있으며, 더 많은 기업과 연구 기관이 TPU를 사용하여 머신 러닝 및 딥러닝 프로젝트를 가속화하고 있습니다.

6. 결론

TPU는 구글이 개발한 특수한 하드웨어로, 대규모 머신 러닝 워크로드를 가속화하는 데 사용됩니다. 이러한 가속기는 텐서 연산을 병렬로 처리하여 대규모 신경망 모델의 훈련 및 추론을 가속화하고, 전력 효율을 최적화합니다. 미래에는 TPU가 머신 러닝 및 딥러닝 분야에서 더 널리 사용되어 머신 러닝 기술의 발전을 이끌 것으로 기대됩니다.

'IT 이론지식' 카테고리의 다른 글

| CUDA(Compute Unified Device Architecture) (0) | 2024.03.19 |

|---|---|

| PaLM(Patch-wise Learning and Memory) (0) | 2024.03.19 |

| 휴리스틱(Heuristic) (0) | 2024.03.19 |

| 데이터베이스 무결성 (0) | 2024.03.19 |

| ACID(Atomicity, Consistency, Isolation, Durability) (0) | 2024.03.19 |